Fazit

Die folgende Seite fasst zentrale Erkenntnisse der Umsetzung zusammen, benennt Stärken und Herausforderungen des entwickelten Systems und skizziert mögliche Perspektiven für Optimierung und Weiterentwicklung.

Ergebnisse & Bewertung des Prototyps

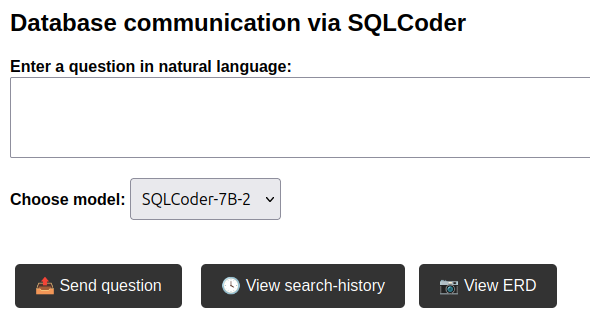

Das entwickelte System erfüllt die gesetzten Ziele in weiten Teilen: Es besteht aus einem modularen, lokal ausführbaren Backend, das SQLCoder-7B-2 zur Abfragegenerierung nutzt, sowie einer Web-Oberfläche mit History-Funktion und ERD-Anzeige. Die Architektur folgt bewährten Best Practices und ermöglicht eine klare Trennung von Komponenten.

Die Benutzeroberfläche erlaubt eine einfache Interaktion mit dem System. Nach dem Start wird eine Eingabemaske mit optionaler Historie angezeigt.

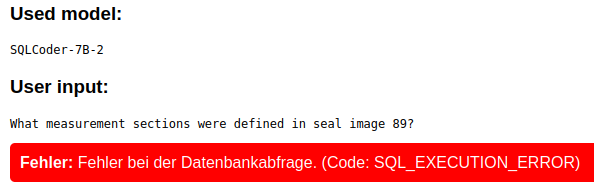

Kommt es zu Fehlern bei der Abfragegenerierung, erhält die Nutzerschaft eine direkte Rückmeldung.

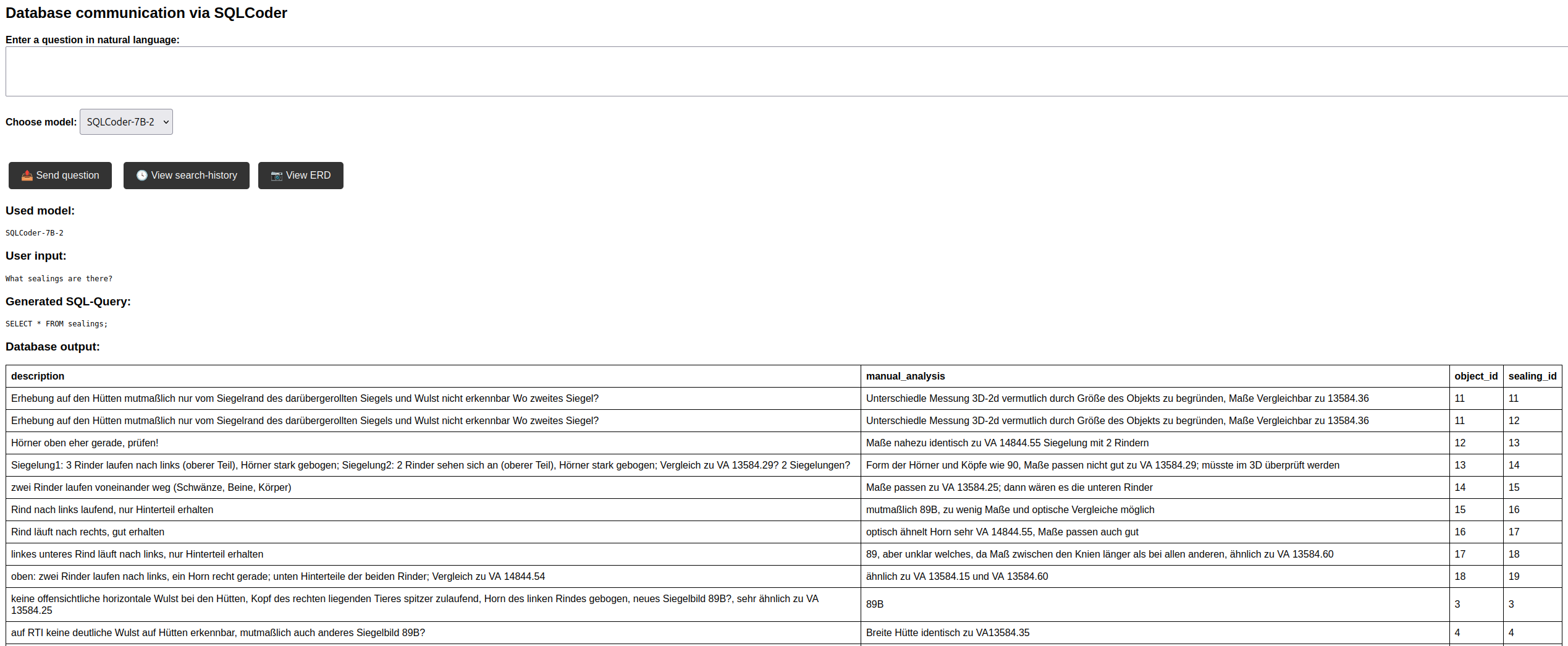

Einfachere Abfragen werden vom Modell in der Regel korrekt umgesetzt.

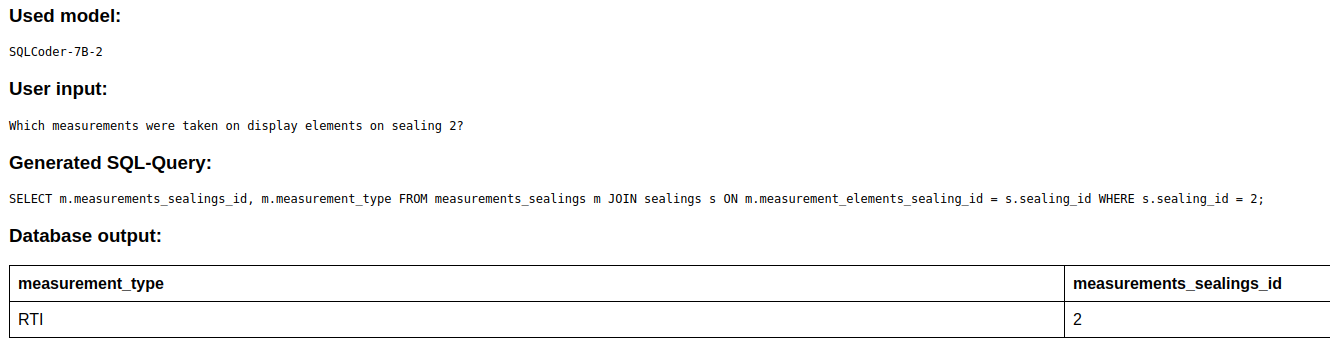

Bei komplexeren Anfragen kommt es jedoch regelmäßig zu semantischen Fehlern. Ein Beispiel zeigt, wie das Modell eine falsche Spalte referenziert, wodurch zwar ausführbare, aber nicht sinnvolle SQL-Statements entstehen.

Die Integration von „Natural Views“ zur besseren Modellinterpretation hat sich als hilfreiche Strategie erwiesen. Dennoch bleibt die Qualität der Modellantworten in komplexeren Fällen unzureichend. Insbesondere die Begrenzung der Kontextlänge durch den verfügbaren GPU-Speicher verhinderte den geplanten Einsatz umfangreicher Few-Shot-Beispiele zur Verbesserung der Modellleistung.

Trotz dieser Einschränkungen war die Wahl von SQLCoder sinnvoll. Die aktive Community, die offenen Modellvarianten und der lokal ausführbare Aufbau waren zentrale Erfolgsfaktoren für die Entwicklung. Alternativen wie PremSQL oder OmniSQL bieten für künftige Iterationen spannende Ansatzpunkte – entweder durch ein schlankeres Setup oder durch eine stärkere Orientierung an wissenschaftlichen Anforderungen.

Optimierungsmöglichkeiten des Prototyps

Die Anwendung zeigt funktionale Stärken, aber auch Verbesserungspotenziale. Eine einfache Erweiterung wäre ein Synonym-Glossar, das dem Modell hilft, gleichbedeutende Begriffe korrekt zuzuordnen. Auch die bestehende Umbenennungslogik könnte weiter geschärft werden: Eine konsequentere Trennung ähnlicher Tabellen- und Spaltennamen würde Verwechslungen reduzieren, etwa durch stärker differenzierende Begriffe.

Besonders vielversprechend erscheint ein RAG-Ansatz. Durch die gezielte Bereitstellung relevanter Kontextinformationen ließe sich die Qualität der Modellantworten deutlich verbessern. Der technische Mehraufwand – insbesondere für einen gut abgestimmten Retriever – wäre allerdings nicht unerheblich.

Weitere Optionen wie Chain-of-Thought oder Fine-Tuning wurden bewusst nicht umgesetzt, da sie mit höherem Entwicklungsaufwand verbunden sind. Perspektivisch könnten automatisierte Trainingsdatensätze oder CoT-Erweiterungen wie SQL-Eval jedoch den Einstieg erleichtern.

Erweiterungsmöglichkeiten des Systems

Die Anwendung bietet bereits einen funktionalen Zugang zu komplexen Forschungsdaten. Für eine künftige Weiterentwicklung sind jedoch verschiedene Ausbaustufen denkbar. Eine sinnvolle Ergänzung wäre ein kurzer Hinweistext oder ein Tutorial zur Formulierung effektiver Nutzeranfragen – gerade für weniger datenbankerfahrene Nutzergruppen.

Eine Erweiterung der Weboberfläche um ein integriertes WebGIS würde den bestehenden Zugriff auf die Datenbank deutlich erweitern. Da viele Abfragen in der Forschungspraxis aus der kartografischen Analyse heraus entstehen, könnte die visuelle Darstellung von Ergebnissen die Nutzung und Interpretation spürbar erleichtern.

Ergänzend ließe sich der tabellarische Output durch automatisch generierte Zusammenfassungen in natürlicher Sprache erweitern. So könnten auch komplexe Abfragen leichter verständlich vermittelt werden.

Perspektivisch ließe sich das System zu einer integrierten Dialogplattform weiterentwickeln, in der ein Chat-LLM nicht nur die Nutzeranfrage verarbeitet, sondern auch den passenden Kontext bereitstellt, SQL-Abfragen generiert und die Ergebnisse in natürlicher Sprache zusammenfasst. In Kombination mit einem Retriever und einem eingebundenen WebGIS könnte so eine durchgängige, interaktive Oberfläche entstehen, die den gesamten Analyseprozess von der Anfrage bis zur Interpretation abdeckt.